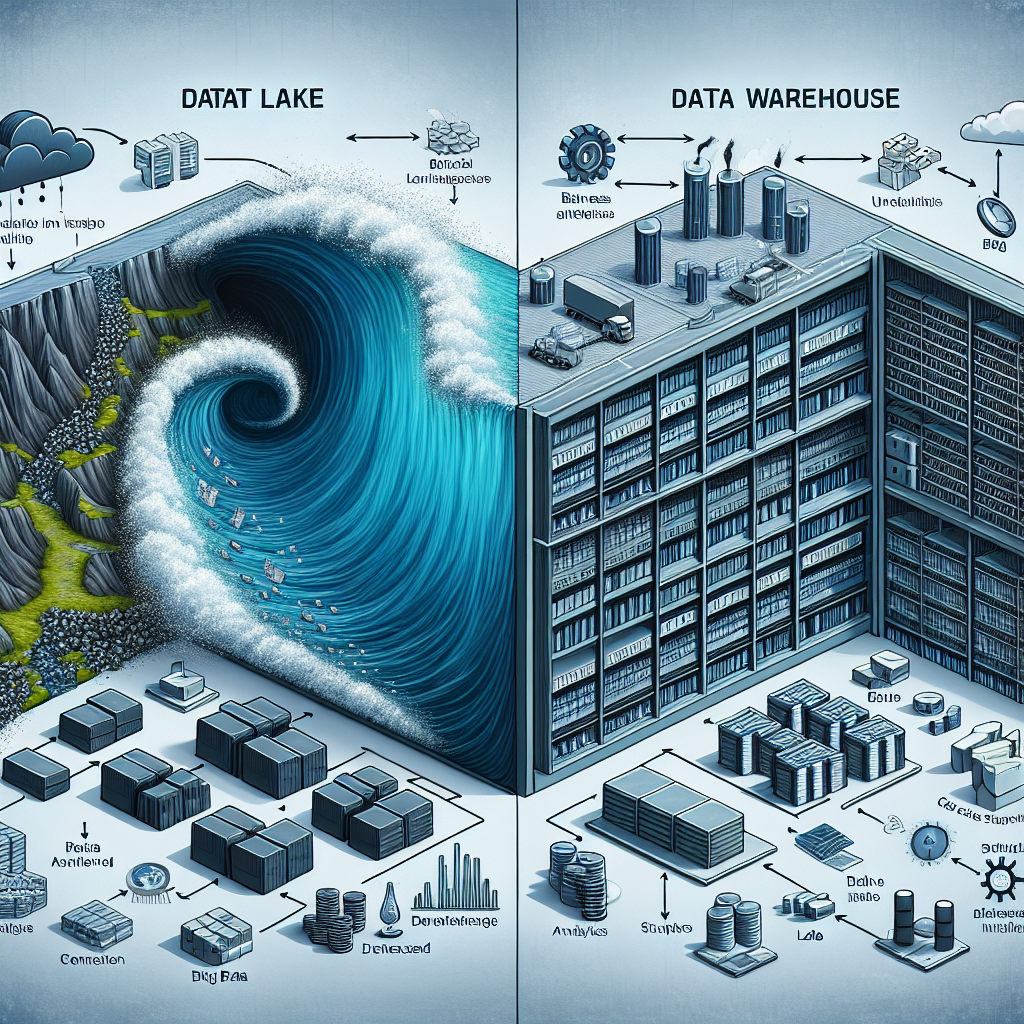

Data Lake vs “Data Warehouse”: Arsitektur Data untuk Analitik Logistik

Pilihannya sering membuat bingung: apakah tim logistik Anda butuh **data lake** yang fleksibel atau **”data warehouse”** yang terstruktur? Dalam artikel ini saya jelaskan perbedaan, kapan pakai masing‑masing, dan arsitektur praktis untuk analitik logistik — disampaikan dengan bahasa yang mudah dimengerti, contoh nyata, dan jawaban cepat untuk pertanyaan umum.

Mengapa arsitektur data penting untuk analitik logistik?

Bayangkan Sari, manajer operasi di perusahaan pengiriman. Ia ingin mengurangi keterlambatan pengiriman, prediksi waktu kedatangan, dan mendeteksi anomali kendaraan real‑time. Data datang dari GPS, sensor suhu, catatan driver, invoice, dan foto kerusakan. Tanpa arsitektur data yang tepat, data ini tercecer, sulit digabung, dan insight yang dihasilkan terlambat atau tidak akurat.

Arsitektur data yang baik membantu mengumpulkan, menyimpan, memproses, dan menyediakan data untuk analitik — apakah itu laporan BI, machine learning, atau dashboard real‑time.

Apa itu Data Lake?

Data lake adalah tempat penyimpanan terpusat untuk data mentah dari berbagai sumber: terstruktur, semi‑terstruktur, dan tak terstruktur. Prinsip utama: simpan data apa adanya dan tentukan struktur saat dibaca (schema‑on‑read).

- Kelebihan: sangat fleksibel, biaya penyimpanan relatif rendah, cocok untuk data besar dan beragam (telemetri, gambar, log).

- Kekurangan: tanpa tata kelola bisa jadi “data swamp” — sulit menemukan data berkualitas.

- Use case logistik: penyimpanan stream GPS, data IoT kendaraan, foto klaim, logs sistem rute, dan eksperimen ML.

Apa itu “Data Warehouse”?

“Data warehouse” adalah gudang data terstruktur yang dioptimalkan untuk analitik dan reporting. Data biasanya dibersihkan, distandarisasi, dan dimodelkan sebelum dimasukkan (schema‑on‑write).

- Kelebihan: performa query tinggi untuk dashboard BI, konsistensi data, lebih mudah untuk compliance dan audit.

- Kekurangan: kurang fleksibel untuk jenis data baru; biaya pemrosesan dan storage untuk data besar bisa lebih tinggi.

- Use case logistik: laporan keuangan pengiriman, SLA monitoring, analisis historis delivery time dan KPI operasional.

Perbandingan cepat: Data Lake vs “Data Warehouse”

- Struktur: Lake = schema‑on‑read; Warehouse = schema‑on‑write.

- Jenis data: Lake = terstruktur & tak terstruktur; Warehouse = umumnya terstruktur.

- Kecepatan query: Warehouse unggul untuk query ad‑hoc BI; lake butuh engine tambahan (mis. Presto, Athena, Spark).

- Biaya: Penyimpanan dasar di lake lebih murah; namun total biaya bisa bertambah untuk processing dan indexing.

- Governansi: Warehouse lebih siap untuk compliance; lake perlu metadata/catalog dan kebijakan kuat.

Arsitektur praktis untuk analitik logistik (3 pola)

1) Hybrid: Data Lake + Data Warehouse (most common)

- Ingest data mentah ke Data Lake (S3, ADLS, dsb).

- Proses ETL/ELT untuk membersihkan & mengubah data menjadi dataset kurasi.

- Masukkan dataset kurasi ke Data Warehouse untuk reporting dan BI.

Contoh: stream GPS masuk ke lake, batch transform menghasilkan rute harian, lalu dimasukkan ke warehouse untuk dashboard SLA.

2) Lakehouse (arsitektur terpadu)

Lakehouse menggabungkan fleksibilitas lake dengan kemampuan query warehouse (mis. Delta Lake, Iceberg). Cocok jika Anda ingin satu lapisan data untuk ML dan BI tanpa duplikasi besar.

3) Streaming-first untuk real‑time operations

- Gunakan event streaming (Kafka, Kinesis) untuk ingest real‑time.

- Stream processing (Flink/Spark) untuk enrich dan deteksi anomali.

- Hasil disimpan di serving layer (low‑latency DB atau materialized views) untuk dashboard operasi.

Pertimbangan teknis penting

- ETL vs ELT: ELT umum di data lake karena transformasi dilakukan setelah data tersimpan; ETL tradisional dipakai untuk warehouse untuk menjamin kualitas sebelum load.

- Catalog & Metadata: gunakan data catalog (mis. AWS Glue, Data Catalog) agar data di lake mudah ditemukan dan diaudit.

- Keamanan & Governance: enkripsi, role‑based access, masking PII untuk kepatuhan regulasi.

- Partitioning & Compression: penting untuk performa dan biaya saat menyimpan data telemetry besar.

- Monitoring & Observability: pipeline perlu alerting pada lag, error, dan data drift untuk operasional logistik yang andal.

FAQ — Pertanyaan yang sering muncul

Q: Mana yang lebih murah, data lake atau data warehouse?

A: **Secara storage murni**, data lake biasanya lebih murah. Namun total biaya bergantung pada kebutuhan query, frekuensi transformasi, dan tools yang dipakai. Warehouse bisa lebih cost‑efficient untuk query analitik intensif karena optimisasi yang lebih baik.

Q: Apakah harus memilih salah satu? Bisakah pakai keduanya?

A: Banyak organisasi memakai kombinasi. Gunakan data lake untuk menyimpan sumber mentah & ML, dan data warehouse untuk reporting bisnis. Pendekatan hybrid memberikan fleksibilitas dan konsistensi.

Q: Bagaimana migrasi legacy warehouse ke lakehouse?

A: Migasi bertahap: evaluasi dataset kritis, replikasi data, verifikasi query/performa, dan latih tim pada tool baru. Mulai dengan use‑case kecil (mis. one KPI) sebelum skala penuh.

Q: Bagaimana menangani data real‑time untuk pelacakan armada?

A: Gunakan streaming ingestion + stream processing untuk enrich dan deteksi anomali, lalu materialize hasil ke serving DB untuk dashboard. Data lake tetap menyimpan event mentah untuk reprocessing dan model ML.

Q: Tools apa yang cocok untuk tim kecil?

A: Untuk tim kecil, pilih solusi managed: penyimpanan objek (S3/ADLS), query on‑data (Athena/BigQuery), dan pipeline managed (Fivetran, Airbyte). Ini mengurangi overhead operasional.

Q: Bagaimana memastikan data quality untuk analitik logistik?

A: Terapkan validasi saat ingest, data tests (Great Expectations), monitoring drift, dan proses reconciliation antara sumber (mis. TMS vs ERP) secara berkala.

Kapan memilih masing‑masing secara praktis?

- Pilih **Data Lake** jika: Anda punya banyak jenis data (sensor, gambar, logs), sering melakukan eksperimen ML, dan butuh fleksibilitas.

- Pilih **”Data Warehouse”** jika: fokus pada laporan bisnis, KPI yang stabil, dan membutuhkan performa query tinggi serta compliance.

- Pilih **Lakehouse/Hybrid** jika: ingin satu platform yang melayani ML + BI tanpa replikasi data berlebihan.

Tip cepat: mulailah dari kebutuhan bisnis: apa KPI terpenting (on‑time delivery, cost per shipment, first‑mile visibility)? Bangun pipeline yang menghasilkan KPI tersebut lebih dulu, lalu scale arsitektur sesuai kebutuhan.

Penutup

Dalam dunia logistik yang datanya cepat dan beragam, tidak ada satu jawaban tunggal untuk arsitektur data. Pahami kebutuhan operasional, kemampuan tim, dan tujuan analitik Anda. Kombinasi data lake untuk fleksibilitas dan “data warehouse” untuk reporting seringkali menjadi solusi yang paling praktis — atau pertimbangkan lakehouse untuk pendekatan terpadu. Jika Anda mau, saya bisa bantu merancang arsitektur contoh berdasarkan kasus pengguna atau anggaran tim Anda.

Semoga membantu — selamat membangun sistem data yang membuat operasi logistik Anda lebih cerdas dan tangkas!